blog

AIブログ

ディープフェイクとは?作成方法や技術、生成ツールを徹底解説

AIの発展によりフェイク動画がyoutubeなどの動画サイトを中心に様々なメディアで取り上げられています。

ディープラーニング(深層学習)であるAI技術を用いて作成されるフェイク動画であるディープフェイク。

様々な活用が期待される一方、著名人へのなりすまし、動画など悪用の可能性も懸念されています。

本記事では、ディープフェイクの作り方、ディープフェイク作成の技術について、その技術的な部分をAI研究開発会社である弊社がわかりやすく解説します!

単にアプリを用いてディープフェイク動画を作成したい、作り方を知りたいという方もいると思います。

ディープフェイク動画は専用のアプリを使えば簡単に誰でも作成することが可能です。

ディープフェイクとは

ディープフェイクとは、ディープラーニング(深層学習)技術を使って作成された非常にリアルな映像や音声のことです。

ディープフェイクは、実在する人物の顔や音声を別の映像や音声に合成することで、本物と見分けがつかないほど精巧なコンテンツを生成することができます。

ディープフェイクの「ディープ」はディープラーニング(深層学習)を、「フェイク」は偽物を意味しています。

ディープラーニングは、多層ニューラルネットワークを使って大量のデータを学習し、パターンを認識する技術です。

この技術を活用することで、AIが動画内の人物の特徴や音声の特性を詳細に学び、リアルな映像や音声を生成できるのです。

ディープフェイクは、映画やテレビ番組、バーチャルタレントやAIアナウンサーの作成、歴史上の人物の再現など、あらゆる分野で活用されています。

ディープフェイクに用いられる技術”GAN”とは?

ディープフェイク動画を作るうえで使われる、GANというAIの技術があります。

GANは、2014年に発表されたもので、主にGenerator(生成ネットワーク)とDiscriminator(識別ネットワーク)という、2つの過程からなっています。

1つ目の過程は偽のデータ(例えばディープフェイク動画)を作成する技術のことです。

偽のデータは可能な限りハイクオリティを目指して作られ、本物により近いデータを作りだします。

そして作った偽のデータが偽であるか、そうでないか(ディープフェイク動画が本物かどうか)を判断するのがもうひとつの過程です。

この2つの過程を通して、偽のデータの作成、そのデータが偽であるかどうかの判定をし、精度を改善していくことで、より偽のデータを本物に近づけていきます。

例えるならば「どろけい」のように、警察(偽物であるか判断をする)が泥棒(偽のデータを生成する)を捕まえる(偽物であることをみやぶる)をして、

仲間の泥棒により捕まった泥棒が逃げ出す(偽物の動画を作成する技術が向上する)。

そして警察が再び逃げた泥棒を捕まえるために、策をねったりする(偽物を判定することが出来る技術の向上をする)を繰り返すということに似ています。

ディープフェイクはこのGANと呼ばれる手法のAI技術などを応用し作られたものです。

単純に顔を入れ替えているのではなく、Aさんの顔の表情筋を細かくパーツ毎に分解して解析します。

そして学習(ディープラーニング)した結果をもとに、Bさんの表情筋を解析してAさんのパーツを当てはめることで、自然な表情を作ることができるのです。

パーツ自体はAさんのものを使用していますので、表情も滑らかに変化し違和感はありません。

何も知らない人がディープフェイク動画だと気付くのは困難です。

そのため著名人へのなりすましやアダルト動画への悪用が起きるのです。

「そんなフェイク動画に騙されたくない。気づくためには?」という人は以下の記事をご覧ください!

ディープフェイク動画を生成する際の技術を紹介

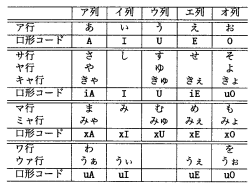

日本語の口の変化

日本語の発声時の口形は、母音/a/,/b/,/c/,/d/,/e/の口形と口を閉じた形である閉口形である/x/をあわせた基本口形からなります。

母音/a/,/b/,/c/,/d/,/e/の口形と口を閉じた形である閉口形である/x/をあわせた基本口形を、

B = {A,I,U,E,O,X}

とし、次に、母音口形の前に形成される口形を、”初口形”=F、発音した音の母音に相当する口形を”終口形”=Lとすると、基本形を用いて

F = {I,U,X}、 L= {A,I,U,E,O,X}

と表します。

初口形は日本語すべての音で形成されますが、終口形は音によって形成されない場合もあります。

そのため、初口形をf(f∈F)、終口形をl(l∈L)としたとき、日本語の発声時の口形は’l’または’fl’という記号で表すことが可能になります。

口形変化を初口形と終口形の組み合わせで表すと次のようになります。

また、撥音便や促音便に関しては、決まった口形がなく、その前後の音によって口形が変化するので、詳しくは論文を参照してください。

口形変化と発話映像の生成

次は実際に口の動きがどのように変化しているか見てみましょう。

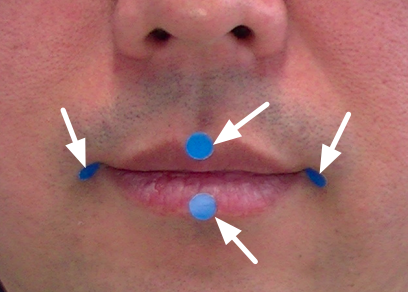

口の動き方の獲得

唇の上下左右にマーカーで青い点を4点付け、マーカーをトラッキングし唇の動きをみてみます。すると下唇が主に動いているだけで残りの3点はあまり変化がありませんでした。

パペット人形も下唇だけを使いますよね。 よってここからは下唇に注目し動きを確認していきます。

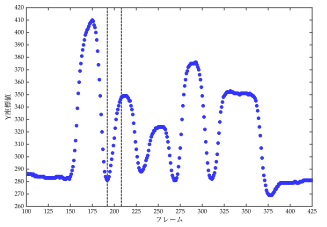

「あいうえお」と発声したときの下唇の動き

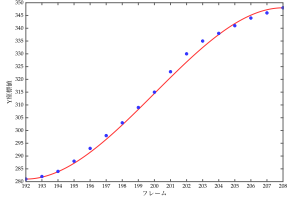

グラフを見ると、放物線を描きながら下唇の位置が変化していることがわかります。

フレームの一部を切り取ると、下唇の変化を3次方程式で表せることがわかります。

CG技術のモーフィングを用いて口形変形画像を生成し、組み合わせることで発話映像を生成します。

さらに、基本口形画像と口形変化画像を組み合わせることにより、発話映像をよりリアルに作ることができます。

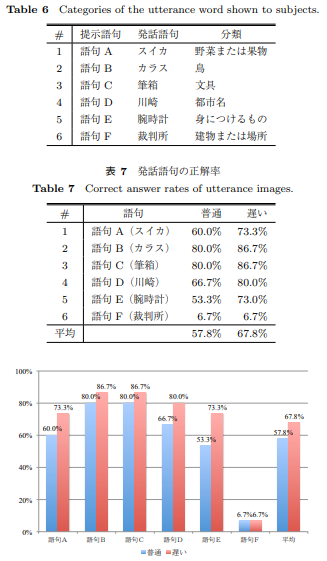

実際に作成した発話映像を用いて、被験者15名に発話映像から読唇できるかという実験があります。

その研究結果は以下のようになり、発話内容を理解することのできる映像を生成できたと言えます。

発話映像の読み取り実験

ディープフェイク動画の作り方

次にディープフェイク動画の作り方について説明します。

多くの場合、専用のツールを使うことが多く、主な作成手順は以下の通りです。

素材の準備

まず、元となる動画と合成したい人物の画像や動画を用意します。

生成ツールの選択

次に、ディープフェイク加工をするために生成ツールを選びます。

例えば、DeepMovieCreatorやDeepFaceLabなどがあります。

初心者の場合、UI、UXが親切な使いやすいアプリから始めるのがおすすめです。

顔の検出と分析

選んだツールを使って、元の動画から顔を検出し、同時に合成したい人物の顔も分析します。AIが顔の特徴点(目、鼻、口など)を識別し、それぞれの動きや表情の変化を元の画像で再現します。

顔の置き換え

分析したデータを基に、AIが新しい見た目を生成し、元の動画に合成します。

音声の合成(オプション)

音声も変更したい場合、音声合成技術を使用します。

自分の声のサンプルを録音し、AIがそれを学習して、自分の声で話しているように変換することができます。

後処理

最後に、画像編集ツールを使い、色調整やブレンディングを行い、より自然な仕上がりにします。

顔と首のつなぎ目を自然に見せたり、光や影の程度を調整したりすることで、よりディープフェイクに見えない仕上がりとなります。

ディープフェイクを作成するツールを紹介

DeepAIMovie

DeepAIMovieは、AIを活用して動画制作プロセスを最初に簡素化するツールです。

このサービスの最大の特徴は、ユーザーが提供するテキストコンテンツをベースに、AIアバターを用いた字幕付きの読み上げ動画をAIアバターが画面上で情報を視覚的に伝え、自動生成された字幕と音声ナレーションが内容を補完します。

これにより、ユーザーは専門的な動画編集スキルがなくても特に、YouTubeなどの動画共有プラットフォームでの使用に適しており、動画マーケティング教育やコンテンツの制作者にとって強力なツールとなっております。

DeepAIMovieは、動画制作の自動化と効率化を大切に、クリエイターがより多くのコンテンツの質と創造性を集中できるよう支援しています。

DeepFaceLab

DeepFaceLabは、最も広く使用されているディープフェイク生成ツールの一つで、オープンソースとして提供されています。

”オープンソース”とはツールのソースコードが無償で公開されているという意味で、自由にツールをカスタマイズすることができます。このツールは、顔の合成に特化しています。

FaceSwap

FaceSwapもオープンソースのディープフェイクツールで、DeepFaceLabと同様に顔の入れ替えを行います。

初心者でも使いやすい設計となっており、顔だけでなく、顔のモーフィングや表情の変化も可能です。

また、動作環境が限定されているツールも多いですが、FaceSwapはWindows、Mac、Linuxで動作します。

ディープフェイクの悪用

ディープフェイク技術は、その精度の高さから、悪意を持って利用されるケースが増えています。以下では、ディープフェイクがなぜ悪用されるのか、そして具体的な事例について説明します。

なぜディープフェイクは悪用されるのか

高精度でリアルな動画生成が可能

ディープフェイク技術は、ディープラーニングを用いて非常に高精度な映像や音声を生成することができます。そのため、視聴者がわからないほどのリアルなコンテンツを作成できてしまいます。

技術の発達と普及

ディープフェイクを作成するためのツールやアプリが広く普及しており、専門的な知識がなくても簡単に利用できるようになりました。作成・拡散できる環境が整っています。

政治家なりすまし

ディープフェイク技術は、政治家なりすましにも利用されています。

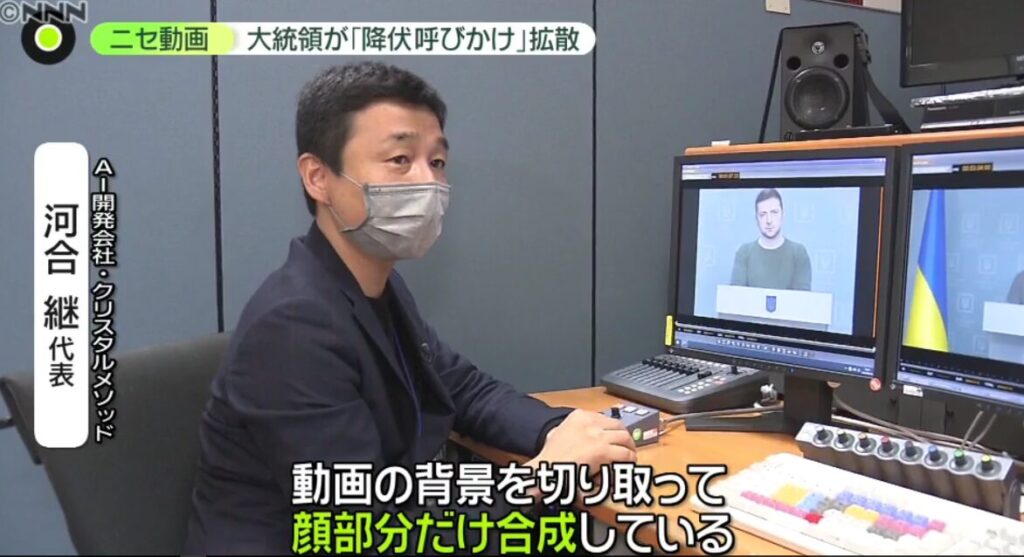

例えば、2022年にウクライナのゼレンスキー大統領になりすました人物が、ロシア軍への抵抗をやめるよう国民に訴える動画が出ました。

このような事例は、一歩間違えれば大多数の犠牲者が出る可能性があり、国民の行動を誤った方向に導く可能性があります。

「降伏」呼びかけ“偽ゼレンスキー大統領” 本物と比較すると…

詐欺

企業のCEOや重役の声をディープフェイクで偽装し、従業員や取引先を騙して報酬を得る事例も報告されています。

例えば、2019年には、海外の企業のCEOの声を偽装して約2,600万円を騙し取る事件が発生しました。

ディープフェイクの悪用防止

セキュリティ対策の強化

企業や個人は、セキュリティ対策を強化する必要があります。

不審なメールやリンクを開いてしまうとハード内の動画や画像を抜き取られてしまい、それを元素材にしたディープフェイク動画が作成されてしまいます。

そのため、セキュリティソフトを最新の状態に守るなど、基本的な対策を徹底することが求められます。

まとめ

ディープフェイクの作り方はいかがだったでしょうか?

ディープフェイクの作り方について解説しましたが、どのように作られているのか理解できたと思います。

ディープフェイクは様々な場面で人の代わりとなり役立つ技術ですが、著名人へのなりすましやアダルト動画への悪用など有害なwebコンテンツに利用される恐れも危惧されています。

ニュースでもウクライナのゼレンスキー大統領のディープフェイク動画がとりあげられ世界でも話題になりました。

クリスタルメソッドでは現在、日本国内の法制化の動向だけではなく欧米の動きや倫理についても考慮しながら、ディープフェイクを始めとしたAI技術の開発を進めています。

特にディープフェイクという観点で弊社では、AIアバターの作成を行なっています。

本記事を最後までお読み頂き、ありがとうございました。

Study about AI

AIについて学ぶ

-

ディープフェイク=怖いだけじゃない?実は“必要とされる理由”と未来の可能性

ディープフェイク=怖いだけじゃない?実は“必要とされる理由”と未来の可能性 ディープフェイク技術。名前を聞くと、どこか怖いイメージを持っている人も多いのではない...

-

未来が爆誕する場所へ——テクノロジーで体感せよ!大阪・関西万博2025

「未来がここにある——テクノロジーで読み解く大阪・関西万博2025」 2025年、大阪にやってくるのは単なる「博覧会」ではない。それは、未來の社会をまるごと体験...

-

AIエージェントの登場!AI企業が目指す“自律型AI”。人間はもうインターフェースなのか?

かつてAIは、ただの道具だった。与えられたプロンプトを実行し、間違いなくタスクを処理する”静かな天才”。だが今、その構図が静かに崩れ始め...